OpenAI lanza una versión de ChatGPT que es gratis, funciona sin internet y corre en laptops y celulares

Según el blog oficial de la compañía, esta nueva línea consiste en dos modelos de IA con diferentes niveles de parámetros, comparables a los modelos o3-mini y o4-mini de OpenAI. Uno de ellos requiere “poca” memoria, por lo que es ideal para su ejecución en dispositivos móviles y laptops.

Los nuevos GPT-OSS-120b y GPT-OSS-20b son de “peso abierto”. Esto significa que sus parámetros de “peso” o de control están disponibles públicamente. Cualquiera puede consultarlos para entender mejor cómo procesan la información. Además, se pueden ejecutar sin conexión a internet y no necesitan protecciones como firewalls.

Ambos modelos son de “bajo costo”, ya que no necesitan grandes niveles de procesamiento para funcionar y están optimizados para su implementación en hardware de consumo. Según OpenAI, superan a otros modelos abiertos de tamaño similar en tareas de razonamiento. Para su entrenamiento, se utilizó una combinación de aprendizaje por refuerzo y técnicas de otros modelos más avanzados de la compañía, como los de la serie o3, enfocada en el razonamiento.

En el caso de GPT-OSS-120B (con 117 mil millones de parámetros) alcanza un nivel casi igual al de OpenAI o4-mini en las pruebas de razonamiento básico y se ejecuta de forma eficiente en una sola GPU de 80 GB.

Por su parte, la variante más pequeña, GPT-OSS-20B (con 21 mil millones de parámetros), ofrece resultados similares a los de OpenAI o3-mini en las pruebas de rendimiento comunes. Este modelo se puede ejecutar en dispositivos con 16 GB de memoria para tareas de inferencia local, sin necesidad de conexión a internet.

Un entrenamiento enfocado en el razonamiento

Según el blog, ambos modelos se entrenaron con las técnicas “más avanzadas” de preentrenamiento y postentrenamiento, con un énfasis en el razonamiento, la eficiencia y la usabilidad real en una amplia gama de entornos de implementación.

Cada modelo, explica OpenAI, es un transformador que aprovecha la “mezcla de expertos” para reducir la cantidad de parámetros activos necesarios, lo que básicamente actúa como un compresor de tokens. Se utilizaron datos principalmente en inglés, solo de texto, centrados en áreas STEM, programación y cultura general, lo que los hace ideales para este tipo de tareas.

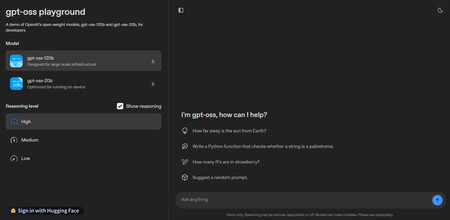

OpenAI también cuenta que los modelos fueron entrenados posteriormente con un proceso similar al de o4-mini, que incluyó una etapa de ajuste fino supervisado y otra de aprendizaje automático de alto rendimiento. El objetivo fue “enseñarles a razonar” antes de que generen sus respuestas. Los desarrolladores pueden configurar este razonamiento con una sola frase en tres niveles diferentes (bajo, medio y alto) para equilibrar la latencia con el rendimiento.

En las evaluaciones de estos modelos, se encontró que GPT-OSS-120B superaba a OpenAI o3-mini e igualaba o superaba a OpenAI o4-mini en codificación, resolución de problemas generales y llamadas a herramientas. También superaba a o4-mini en consultas de salud y matemáticas.

Por otro lado, se descubrió que GPT-OSS-20B es capaz de igualar o superar a OpenAI o3-mini en estas mismas evaluaciones a pesar de tener un número inferior de parámetros, y lograba ponerse por encima en matemáticas y salud.

Existen varios detalles adicionales de interés. Por ejemplo, OpenAI indica que no monitorea de forma directa la “cadena de pensamiento” de estos modelos. Este es un proceso que intenta replicar el razonamiento humano antes de resolver un problema, lo que permite al modelo reconocer y corregir errores, simplificar pasos y probar diferentes enfoques cuando el original no funciona.

Esta falta de monitorización directa se aplica a los GPT-OSS. Aunque el monitoreo puede ser útil para detectar conductas inapropiadas, OpenAI espera que esta apertura permita a los desarrolladores crear sus propios sistemas de vigilancia. Por esta razón, advierten que los modelos pueden llegar a contener contenido engañoso o dañino, incluido lenguaje que no refleja las políticas de seguridad estándar de la compañía.

El gran “riesgo” de los modelos abiertos

En temas de seguridad, estos nuevos modelos tienen varios enfoques de vanguardia. En la capacitación previa se filtraron ciertos datos perjudiciales relacionados con armas químicas, biológicas, radiológicas o nucleares. En la capacitación posterior, se usó una alineación deliberativa y una jerarquía de instrucciones para enseñarle al modelo a rechazar indicaciones inseguras y a defenderse contra la insistencia de estas peticiones.

Según la compañía, una vez que se publica un modelo de peso abierto,los adversarios lo pueden ajustar con fines maliciosos. Por ello, se consideraron estos riesgos al dar al modelo datos especializados de biología y ciberseguridad. Tras la evaluación, se verificó que, aunque un atacante pudiera realizar ajustes finos, los modelos no fueron capaces de alcanzar niveles de capacidad peligrosos para este tipo de tareas.

Estos procesos marcan un “avance significativo” en la seguridad del modelo abierto, por lo que se espera que ayuden a acelerar la investigación en capacitación y seguridad en toda la industria.

La disponiblidad de los nuevos modelos de OpenAI

De acuerdo con OpenAI, los pesos de GPT-OSS-120B y GPT-OSS-20B estarán disponibles para su descarga gratuita a través de Hugging Face y funcionan con 80 GB y 16 GB de memoria, respectivamente. También estarán en otras plataformas como Databricks, Azure y AWS bajo la licencia Apache 2.0, lo que permite su amplia modificación con fines comerciales.

La interfaz de GPT-OSS de demostración

La interfaz de GPT-OSS de demostraciónEstos modelos tienen también varios diseños de compatibilidad, tanto en Python como en Rust, para hacer más fácil su adopción, además de en PyTorch y Metal de Apple. Se suman consideraciones adicionales quelos hacen más flexibles y fáciles de ejecutar localmente gracias a asociaciones con empresas como Azure, Hugging Face, vLLM, Ollama, llama.cpp, LM Studio, AWS, Fireworks, Together AI, Baseten, Databricks, Vercel, Cloudflare y OpenRouter.

En el hardware, también se trabajó con empresas como NVIDIA, AMD, Cerebras y Groq para garantizar su buen rendimiento en diferentes sistemas.

Adicionalmente, Microsoft tiene varias versiones optimizadas del modelo GPT-OSS-20B para GPUs en dispositivos Windows, de la mano de ONNX Runtime, que admiten inferencia local y se pueden encontrar a través de Foundry Local y el kit de herramientas de IA para VS Code.

Un paso a la democratización de la IA

Según OpenAI, con la llegada de estos modelos, se ofrecen avances“significativos” no solo en la capacidad de razonamiento, sino también en la de seguridad, lo que complementa a los modelos ya disponibles.

La compañía también dice que con estos modelos se reducen las barreras en mercados emergentes, en sectores con recursos limitados o en organizaciones más pequeñas que no tienen el presupuesto o la flexibilidad para adoptar estas tecnologías.