La pregunta que ninguna inteligencia artificial puede resolver

Según un experimento, todos los modelos de IA más populares no pueden dar una respuesta a la misma pregunta y seleccionan el mismo número de manera aleatoria.

Algunos, como Elon Musk, afirman que en unos cinco años la mente humana será superada por la inteligencia artificial. Las herramientas cada vez más avanzadas prometen acelerar la incorporación de la IA generativa en todos los aspectos de la vida diaria.

Los chatbots de última generación que utilizan el modelo de lenguaje completo (LLM) pueden resolver prácticamente cualquier pregunta, incluso las que son poco éticas. Aunque la tecnología ha avanzado, todos los modelos tienen la misma falla.

“¿qué episodio de La isla de Gilligan trataba sobre la lectura de la mente?”, según una prueba de Mind Prison. Seer Gilligan es la respuesta correcta.

Los LLM que comprenden la pregunta ofrecen una respuesta aproximada, pero los datos son inexactos o inexactos:

Opus: “Me disculpo, pero ningún episodio de La isla de Gilligan se enfoca en la lectura mental”.

GPT-4: “Ring Around Gilligan es el episodio de La isla de Gilligan que involucra la lectura mental. Este es el sexto capítulo de la tercera temporada.

Gemini 1.5: “El episodio 12 de la temporada 2 de La isla de Gilligan de la lectura de la mente es el episodio de La lectura de la mente”.

Llama 3: “Después de realizar una búsqueda exhaustiva y revisar las guías de episodios, descubrí que ningún episodio de La isla de Gilligan se centra en la lectura mental”.

Opus y Call 3 afirman que ningún episodio aborda el tema de la lectura mental. Los modelos GPT-4 y Gemini 1.5 muestran información errónea como si fuera real.

Además, el experimento les pidió que seleccionaran un número entre 1 y 100. El 42 fue elegido por todos los modelos de LLM. Este número está muy presente en la información con la que la IA ha sido entrenada. Según el libro de Douglas Adams The Hitchhiker’s Guide to the Galaxy, los chatbots creen que el 42 es la respuesta a las preguntas fundamentales de la vida.

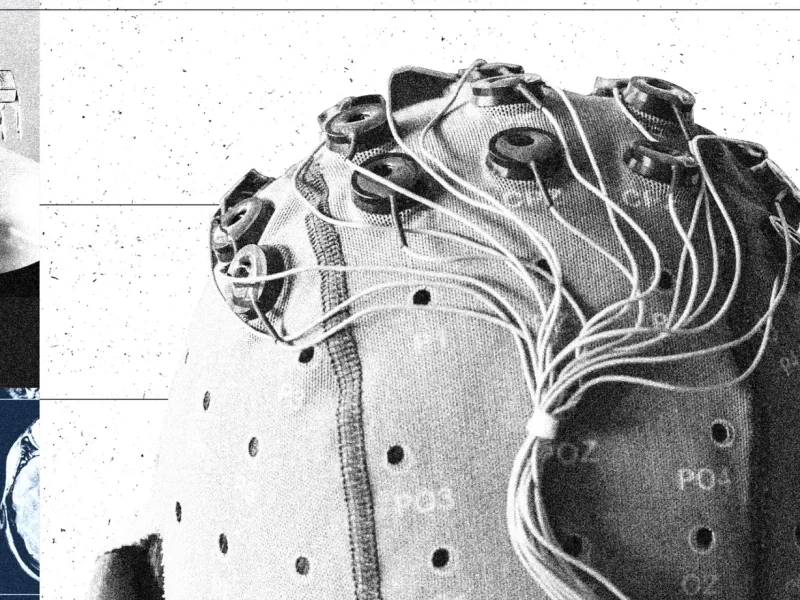

Las herramientas que emplean inteligencia artificial no pueden analizar los datos como lo haría la mente humana. La IA no sabe lo que realmente sabe. Los modelos experimentan alucinaciones como resultado natural de su sistema de entrenamiento y arquitectura.

Solo los LLM pueden hablar sobre información verdadera o falsa. Este modelo no puede producir una idea o una respuesta sin una base, por lo que sus resultados dependen de la lógica que interconecta los datos.

La tecnología avanza y se espera que en unos años los chatbots puedan tomar decisiones, aunque algunas respuestas son imprecisas y otras claramente incorrectas. Elon Musk dice que cuando esto suceda, la probabilidad de que destruya la humanidad es del 20%, mientras que en Sillicon Valley creen que es del 5 al 50%.